En los últimos años, el aprendizaje profundo se ha vuelto cada vez más popular debido a su capacidad para resolver problemas complejos en diferentes áreas. Uno de los elementos cruciales del aprendizaje profundo es la función de activación, que se utiliza para determinar la salida de cada neurona en una red neuronal. En este artículo, hablaremos sobre la Función Unidad Rectificada Uniforme (RELU), una herramienta esencial para el aprendizaje profundo.

Introducción a la Función Unidad Rectificada Uniforme (RELU)

La Función Unidad Rectificada Uniforme (RELU) es una función de activación no lineal que se utiliza en redes neuronales profundas. Esta función fue introducida por Hahnloser et al. en 2000 y popularizada por Krizhevsky et al. en 2012. Desde entonces, se ha convertido en una de las funciones de activación más utilizadas en el aprendizaje profundo debido a su simplicidad y eficacia.

Funcionamiento de la Unidad Rectificada Uniforme (RELU)

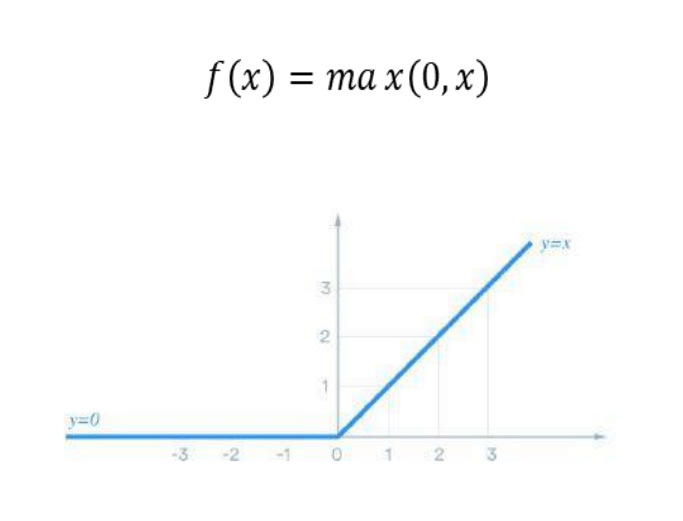

La Función Unidad Rectificada Uniforme (RELU) se define matemáticamente como f(x) = max(0, x), donde x es una entrada a la neurona y la salida es el valor máximo entre 0 y x. En otras palabras, la función RELU toma cualquier entrada x y devuelve 0 si x es negativo, o x si es positivo.

Ventajas de la Función Unidad Rectificada Uniforme (RELU)

La Función Unidad Rectificada Uniforme (RELU) tiene varias ventajas que la hacen una herramienta esencial para el aprendizaje profundo. En primer lugar, la función RELU es fácil de calcular y no requiere mucho poder de procesamiento. En segundo lugar, la función RELU es menos propensa al problema del desvanecimiento del gradiente, que se produce cuando la derivada de la función de activación es muy pequeña y hace que la actualización de los pesos sea difícil. Por último, la función RELU puede ser utilizada en redes neuronales profundas sin sufrir de la saturación de la activación, lo que puede ocurrir con otras funciones de activación.

Aplicaciones de la Función Unidad Rectificada Uniforme (RELU) en el Aprendizaje Profundo

La Función Unidad Rectificada Uniforme (RELU) es ampliamente utilizada en el aprendizaje profundo para mejorar la precisión y la velocidad del entrenamiento. Esta función se ha utilizado en varios modelos exitosos, como el modelo AlexNet utilizado para la clasificación de imágenes, así como en modelos de procesamiento de lenguaje natural y reconocimiento de voz. Además, la función RELU ha sido utilizada en la creación de redes neuronales convolucionales, que son ampliamente utilizadas en el procesamiento de imágenes y videos.

En resumen, la Función Unidad Rectificada Uniforme (RELU) es una herramienta esencial para el aprendizaje profundo debido a su simplicidad y eficacia. Esta función ha demostrado ser útil en una variedad de aplicaciones, desde la clasificación de imágenes hasta el procesamiento del lenguaje natural y el reconocimiento de voz. Al utilizar la función RELU, los desarrolladores de aprendizaje profundo pueden mejorar la precisión y la velocidad del entrenamiento de la red neuronal, lo que puede llevar a soluciones más eficientes y efectivas para problemas complejos en diferentes áreas.