Las redes neuronales son un tipo de modelos matemáticos y computacionales que imitan el funcionamiento del cerebro humano. Son ampliamente utilizados en diversas áreas, como el procesamiento de imágenes, el reconocimiento de voz, el aprendizaje automático, entre otros. Para que una red neuronal funcione correctamente, es necesario utilizar diferentes funciones de activación. En este artículo, hablaremos de la función Leaky RELU y su papel en las redes neuronales.

Introducción a las Redes Neuronales

Las redes neuronales son un conjunto de algoritmos que intentan reconocer patrones en los datos de entrada, de forma similar a como el cerebro humano trabaja. Estas redes están compuestas por capas de neuronas interconectadas y se utilizan para resolver problemas complejos de clasificación, regresión, segmentación y más.

La idea principal detrás de las redes neuronales es que cada neurona procesa la información de entrada, y luego transmite la señal procesada a las neuronas de la siguiente capa. Esto se hace mediante una función de activación que se aplica a la salida de cada neurona.

La Función Leaky RELU: ¿qué es y cómo funciona?

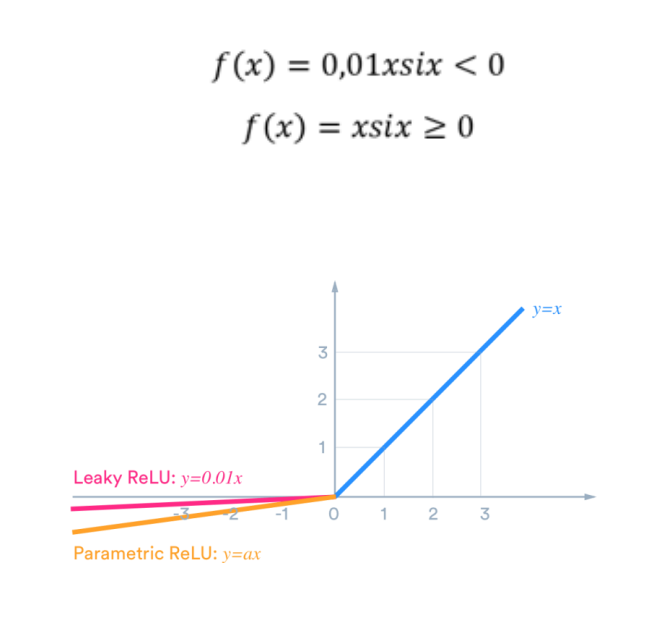

La función Leaky RELU es una función de activación utilizada en las redes neuronales. Esta función es una variante de la función RELU (Rectified Linear Unit), que se utiliza popularmente en las redes neuronales.

La función Leaky RELU es similar a la función RELU, pero en lugar de tener una pendiente cero para valores negativos, tiene una pendiente pequeña. Esto significa que la función no se detiene completamente en valores negativos, lo que puede ayudar a evitar la saturación de la neurona.

La ecuación de la función Leaky RELU es f(x) = { x si x >= 0 ; alpha * x si x < 0}, donde alpha es un número pequeño y positivo.

Ventajas y desventajas de la Función Leaky RELU

La función Leaky RELU tiene varias ventajas. En primer lugar, esta función puede ayudar a evitar la saturación de la neurona, lo que puede mejorar el rendimiento de la red neuronal. En segundo lugar, esta función puede ser más efectiva que la función RELU en algunos casos, especialmente cuando se trabaja con grandes conjuntos de datos.

Sin embargo, la función Leaky RELU también tiene algunas desventajas. En primer lugar, el valor de alpha debe ser elegido cuidadosamente, ya que si es demasiado grande, puede hacer que la función se comporte como una función lineal. En segundo lugar, la función Leaky RELU no es adecuada para todas las tareas, y puede ser menos efectiva en algunos casos.

Aplicaciones de la Función Leaky RELU en las Redes Neuronales

La función Leaky RELU se utiliza en muchas aplicaciones de redes neuronales. Por ejemplo, esta función se utiliza en las redes neuronales convolucionales (CNN), que son ampliamente utilizadas en el procesamiento de imágenes. También se utiliza en las redes neuronales recurrentes (RNN), que se utilizan en el procesamiento del lenguaje natural y en la generación de texto.

La función Leaky RELU también se utiliza en las redes neuronales profundas, que son redes neuronales con muchas capas. Estas redes suelen tener problemas de saturación de la neurona, y la función Leaky RELU puede ayudar a evitar este problema.

En general, la función Leaky RELU es una herramienta útil en el campo de las redes neuronales, que puede mejorar el rendimiento de la red en diferentes tareas.

En resumen, la función Leaky RELU es una función de activación popular en las redes neuronales. Esta función puede ser útil para evitar la saturación de la neurona y mejorar el rendimiento de la red. Sin embargo, también tiene sus desventajas y no es adecuada para todas las tareas. En general, la función Leaky RELU es una herramienta útil en el campo de las redes neuronales, que puede mejorar el rendimiento de la red en diferentes tareas.