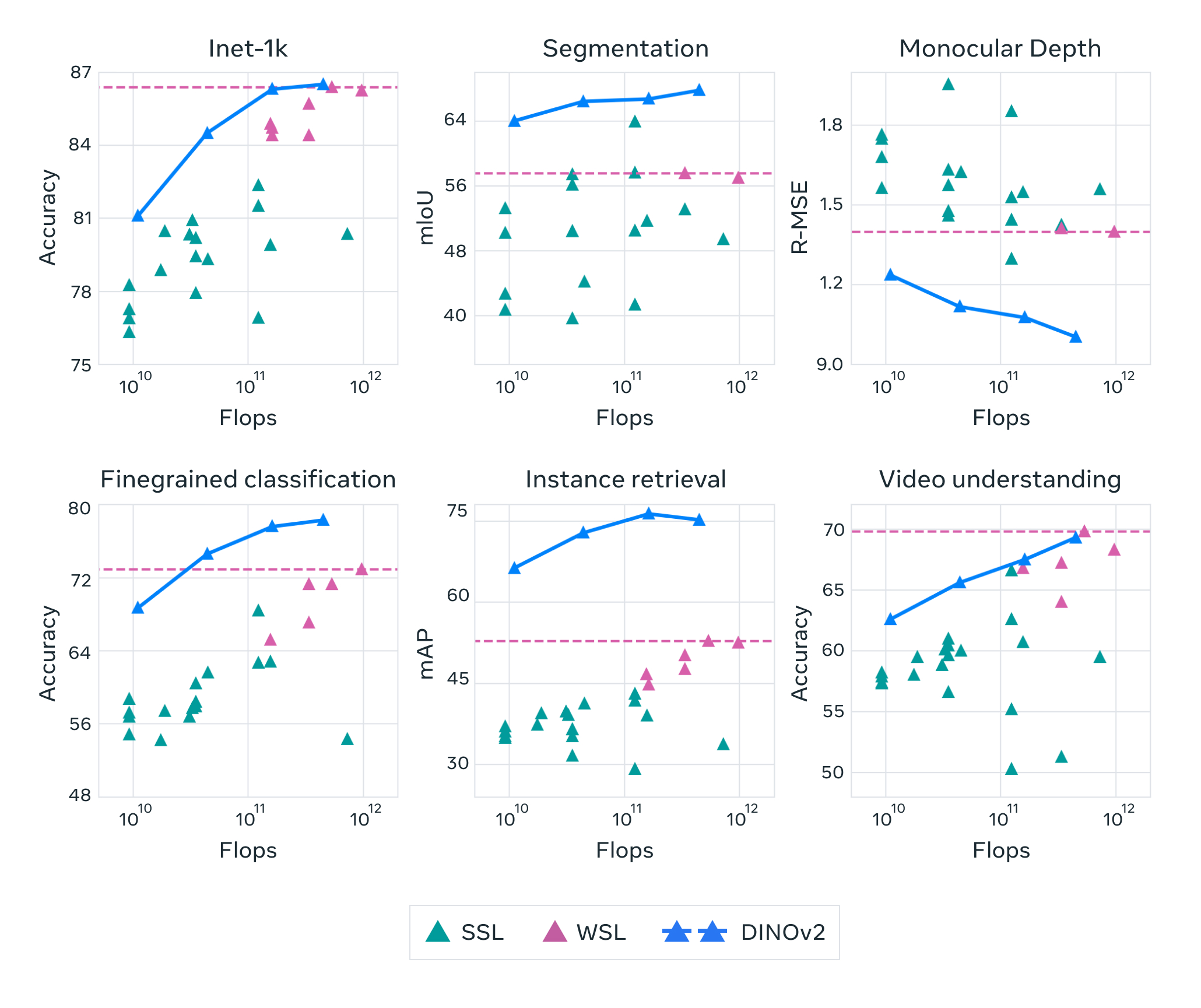

El equipo de Dinov2 ha logrado avances significativos en el autoaprendizaje de visión por computadora, utilizando técnicas de aprendizaje profundo y redes neuronales convolucionales. Los resultados prometen mejorar la capacidad de las máquinas para reconocer objetos y patrones en imágenes de manera autónoma, lo que tiene implicaciones importantes en áreas como la robótica y la Inteligencia Artificial.

Read moreCategory: Inteligencia Artificial

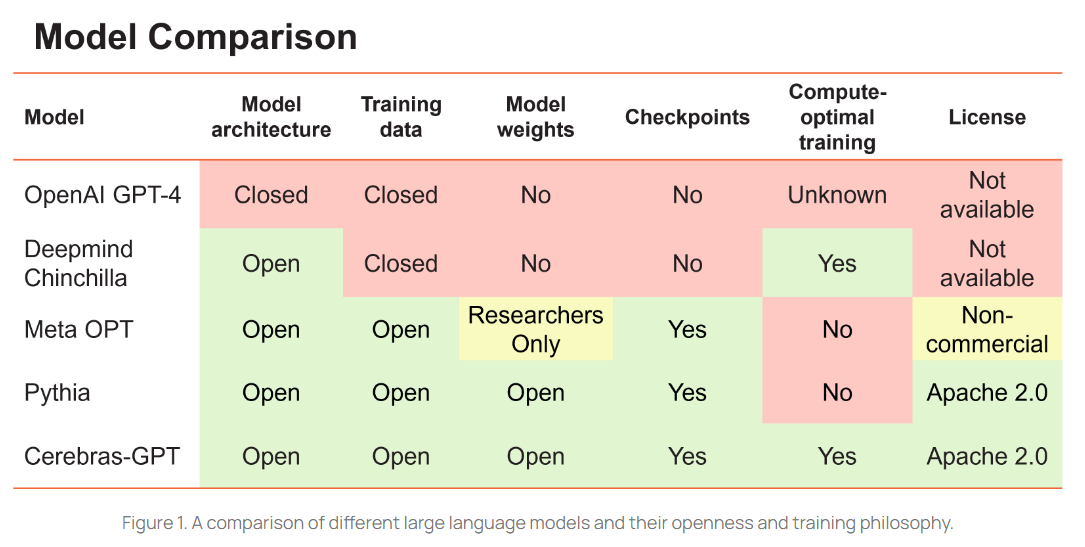

Cerebras-GPT: 7 Modelos LLM Open-Source listos para su uso

Cerebras-GPT es una familia de modelos de lenguaje grandes, abiertos y eficientes que utiliza la tecnología de procesamiento de grafos para mejorar la eficiencia en el entrenamiento y la inferencia. Esta tecnología permite procesar grandes cantidades de datos de manera eficiente, lo que se traduce en una mayor velocidad y precisión en el procesamiento del lenguaje natural. Además, Cerebras-GPT es altamente escalable, lo que permite su adaptación a diferentes tamaños de conjuntos de datos y aplicaciones específicas. En resumen, Cerebras-GPT es una solución altamente eficiente y flexible para procesamiento de lenguaje natural a gran escala.

Read moreComparativa de BD vectoriales: qdrant, pinecone y weaviate.

En este artículo, se realizará una comparativa técnica de las bases de datos vectoriales qdrant, pinecone y weaviate. Se analizarán sus características, rendimiento y escalabilidad, para ayudar a los desarrolladores a seleccionar la mejor opción según sus necesidades.

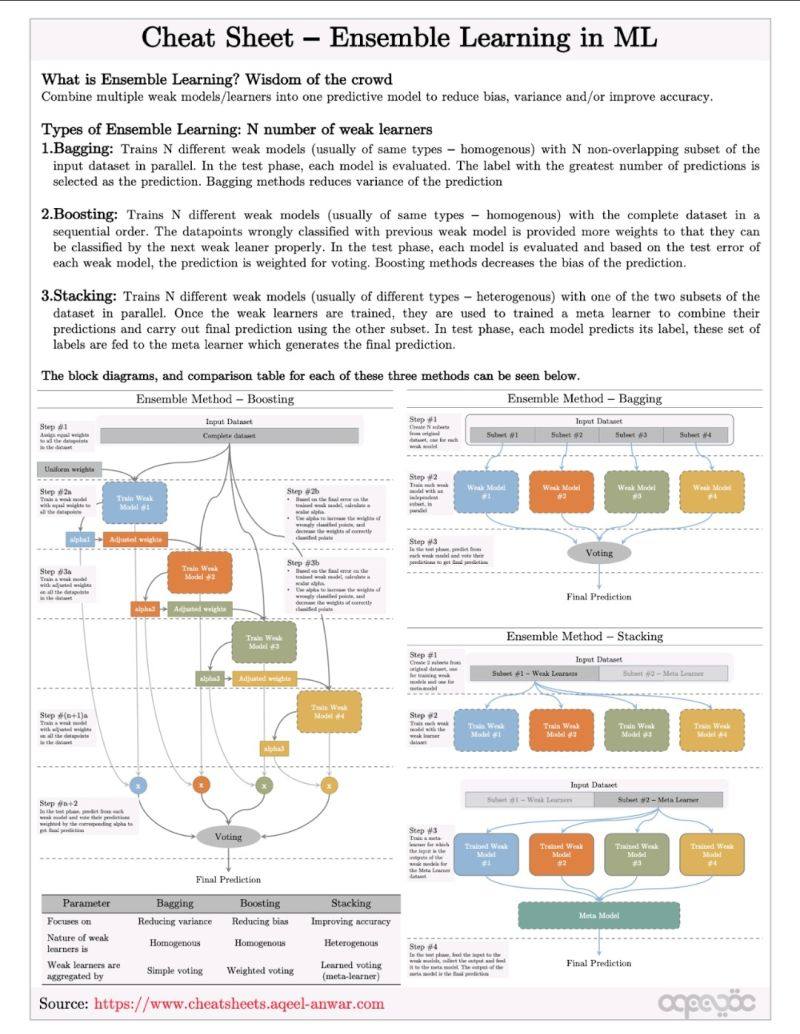

Read moreEnsamble de aprendizaje en ML

El ensamble de aprendizaje en ML es una técnica avanzada que permite mejorar la precisión y la estabilidad de los modelos de aprendizaje automático. Al combinar varios modelos en un ensamble, se pueden superar las limitaciones individuales de cada modelo y obtener resultados más robustos y consistentes. Sin embargo, también hay desafíos importantes en términos de ajuste de hiperparámetros y selección de modelos, por lo que se requiere una cuidadosa planificación y evaluación en la implementación del ensamble. En general, el ensamble de aprendizaje en ML sigue siendo un área de investigación y desarrollo activa en la comunidad de aprendizaje automático, con muchas oportunidades para mejorar y expandir su uso en aplicaciones prácticas.

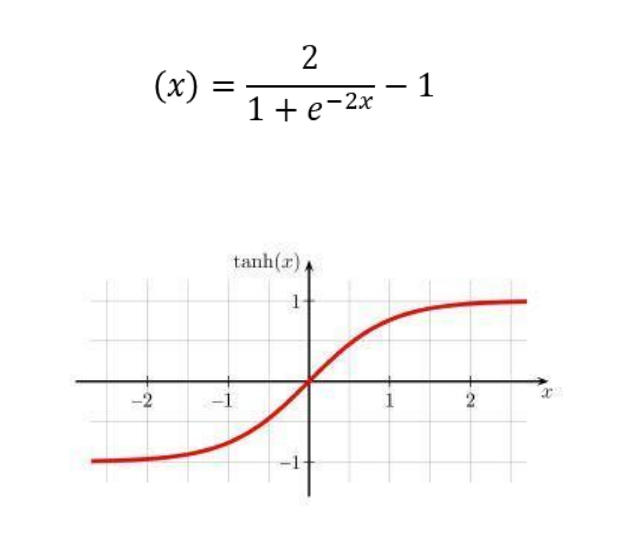

Read moreLa Tangente Hiperbólica: Función de Activación Potente

La tangente hiperbólica es una función de activación potente y muy utilizada en redes neuronales debido a su capacidad para resolver problemas complejos. Su curva de activación proporciona una respuesta no lineal, lo que permite a la red aprender patrones y relaciones no lineales en los datos. Además, la tangente hiperbólica es fácilmente diferenciable, lo que es importante para la retropropagación del error durante el entrenamiento de la red. En resumen, la tangente hiperbólica es una función de activación imprescindible para la construcción de redes neuronales eficientes y precisas.

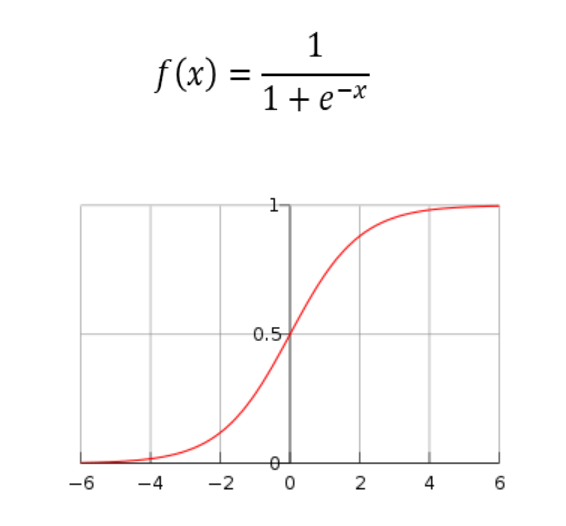

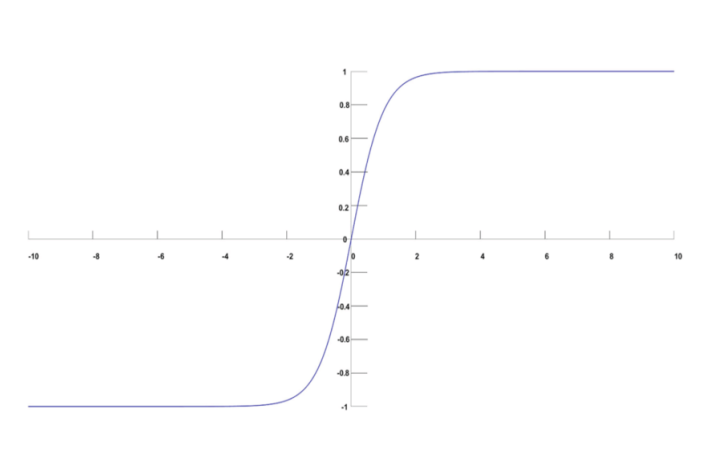

Read moreLa Función Sigmoide: Una Herramienta Clave en Redes Neuronales

La función sigmoide es una herramienta clave en redes neuronales debido a su capacidad para modelar la relación no lineal entre entradas y salidas. Al ser una función continua y diferenciable, es útil para la optimización de parámetros mediante técnicas de aprendizaje automático. Además, su forma de curva en S permite que la salida de la red se encuentre en un rango limitado, lo que mejora la estabilidad y la precisión del modelo. En resumen, la función sigmoide es fundamental para el éxito de las redes neuronales.

Read moreFunción SoftMax: Activación para la clasificación

La Función SoftMax es una herramienta esencial en la clasificación de datos en Machine Learning. Su uso es fundamental para obtener una distribución de probabilidades que permita determinar con precisión la clase a la que pertenece un objeto. En este artículo, exploraremos en detalle las propiedades y aplicaciones de esta función de activación.

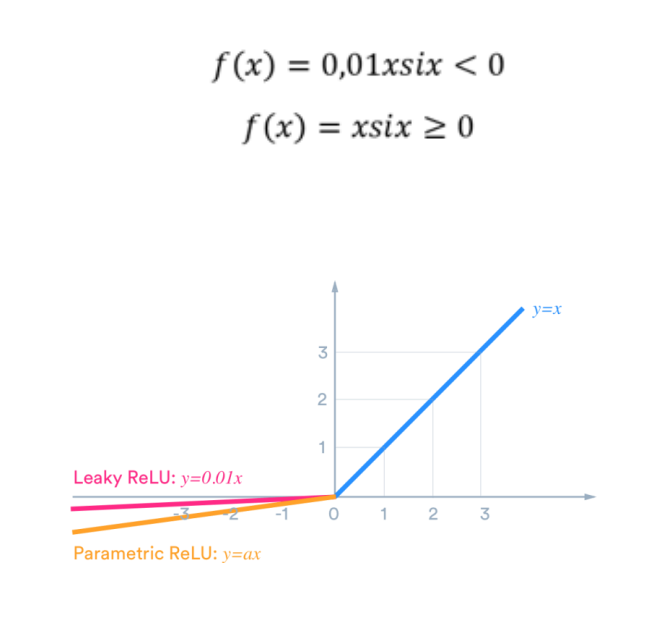

Read moreLa Función Leaky RELU y su papel en las Redes Neuronales

La Función Leaky RELU es una variante de la función de activación RELU que soluciona el problema del “neurona muerta”. Su papel en las redes neuronales es mejorar la precisión de los modelos y reducir el riesgo de sobreajuste.

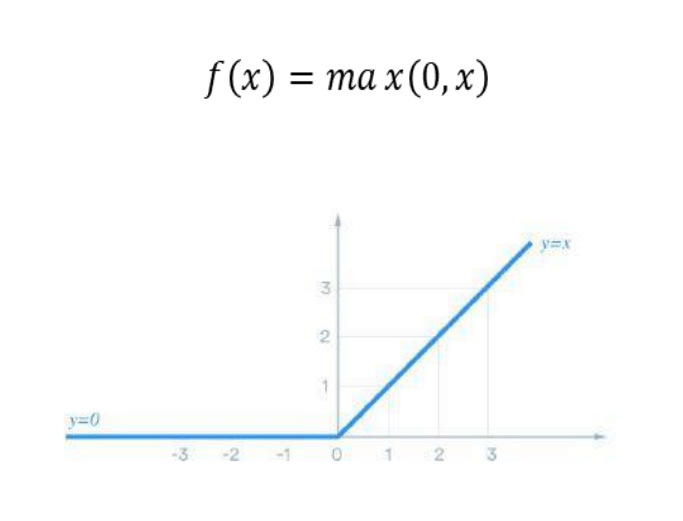

Read moreLa Función Unidad Rectificada Uniforme (RELU): Una Herramienta Esencial para el Aprendizaje Profundo

La función unidad rectificada uniforme (RELU) es una herramienta esencial para el aprendizaje profundo debido a su capacidad para mejorar la precisión y velocidad de los algoritmos de aprendizaje automático.

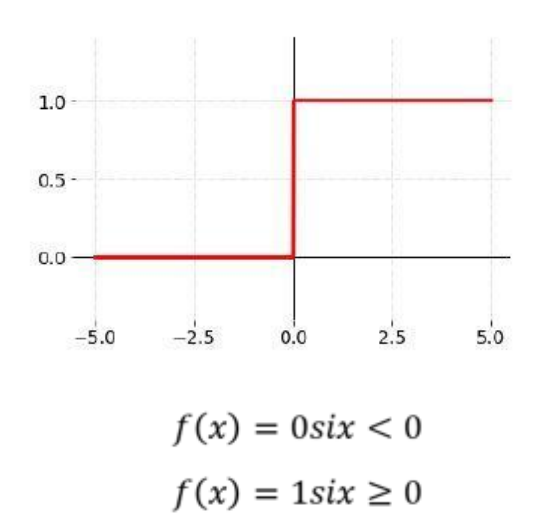

Read moreLa Función Escalón: Una Herramienta Esencial en Redes Neuronales

La Función Escalón es una herramienta esencial en redes neuronales ya que permite la activación de las neuronas y la clasificación de los datos de entrada. En este artículo analizaremos su funcionamiento y su aplicación en diferentes modelos de redes neuronales.

Read more